Disco iSCSI visibile tra i dispositivi ma non tra i datastore

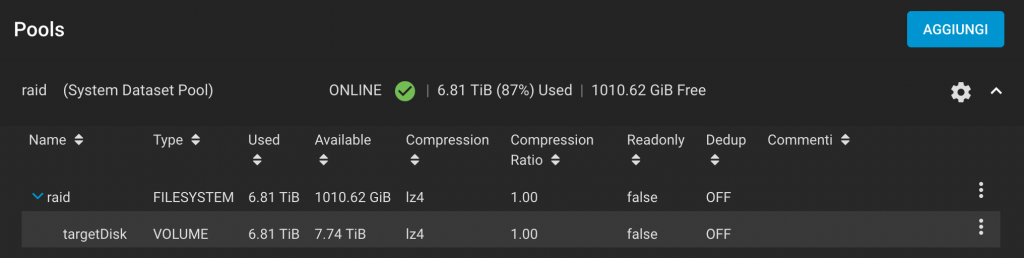

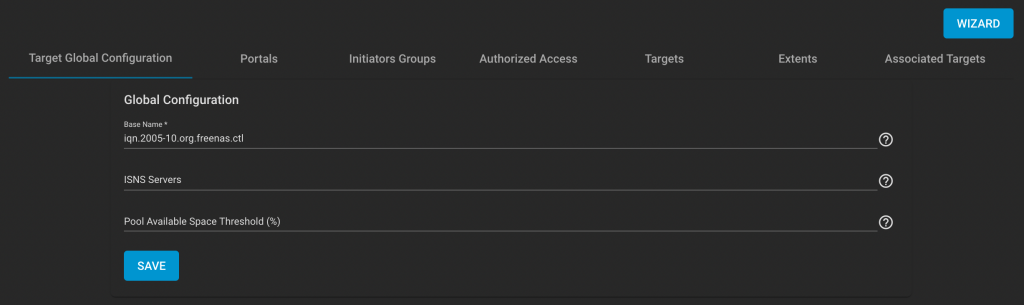

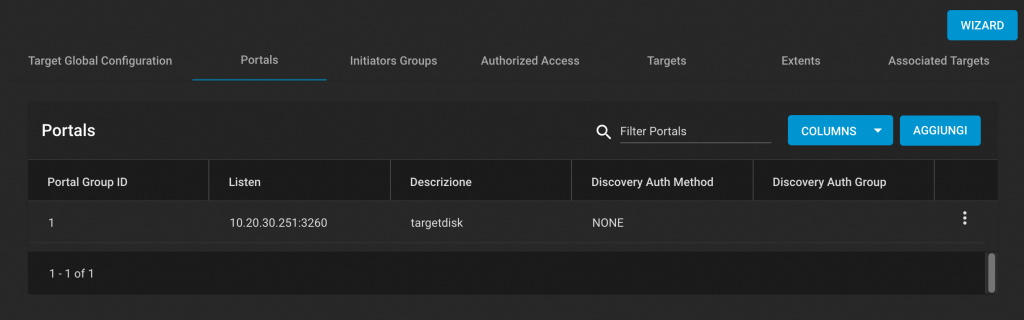

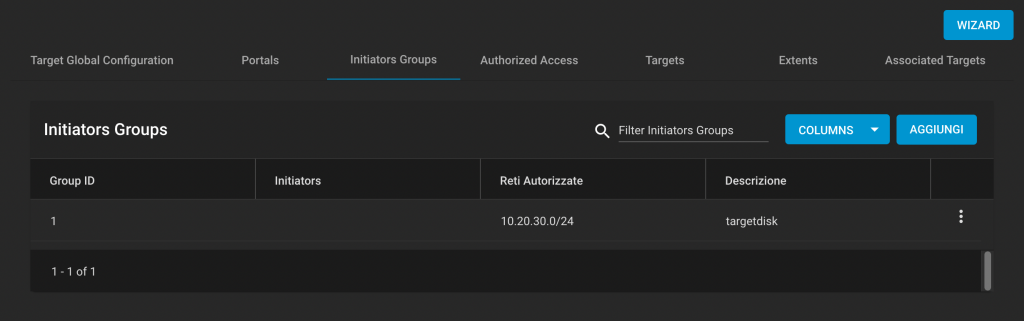

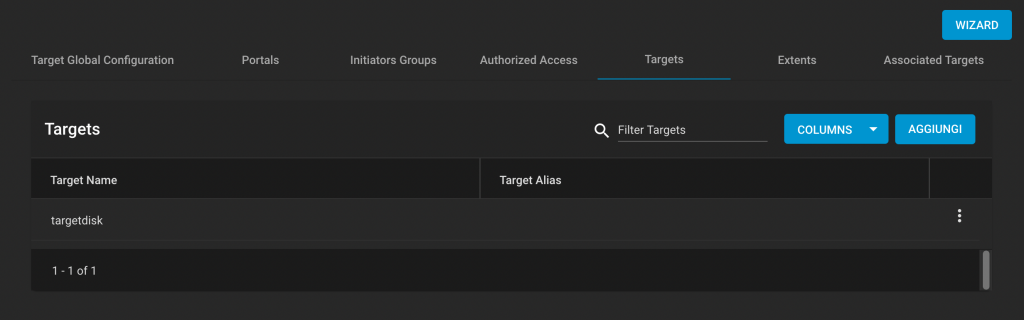

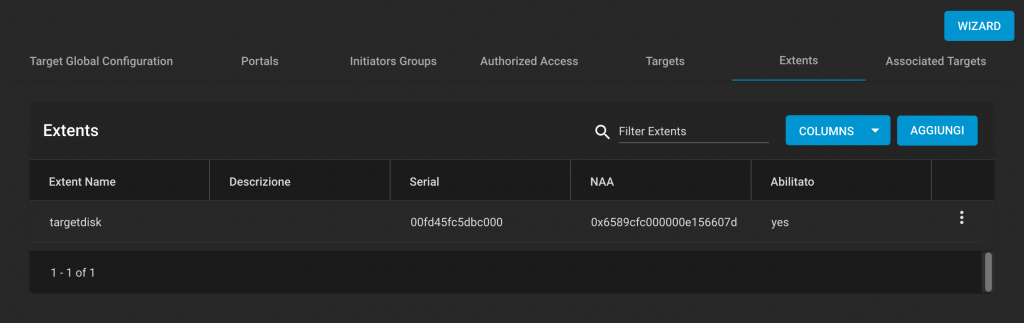

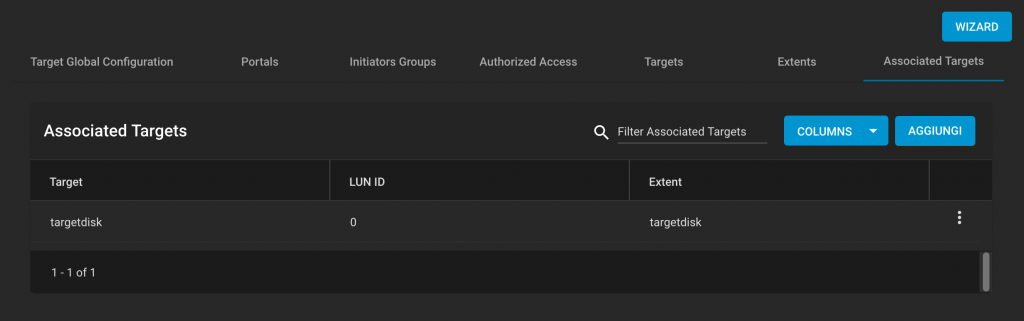

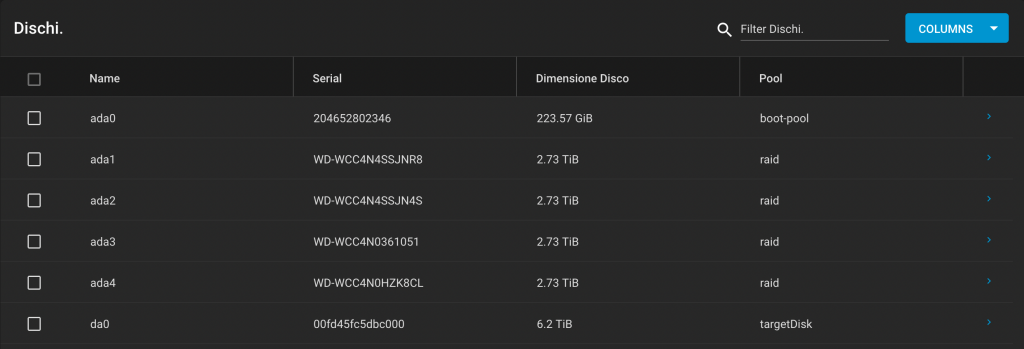

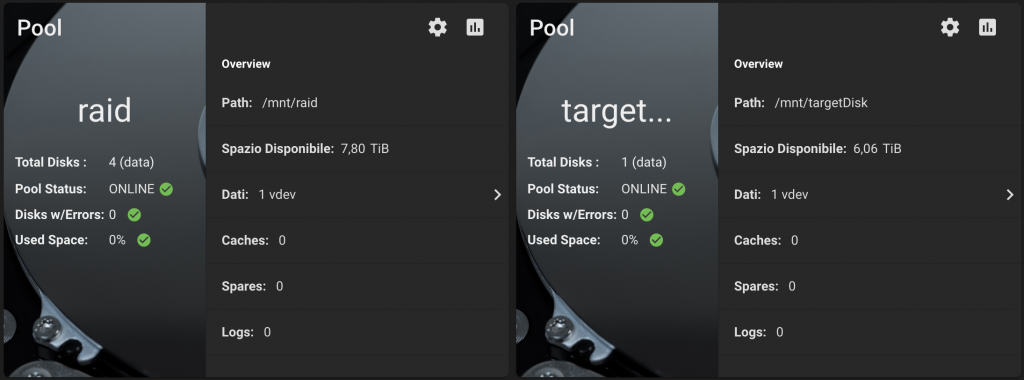

Problema tra sistemi. Ho uno storage con TrueNAS che esporta verso un cluster due dischi iSCSI e una cartella NFS, utilizzati come datastore per le VM.

A causa di un problema con il disco di avvio dello storage ho dovuto reinstallare da zero TrueNAS, versione SCALE 23.10.0.1.

Nessun problema con la reimportazione dei volumi su TrueNAS, pochi aggiustamenti sui permessi e tutto pare tornato a posto.

I dischi iSCSI esportati verso il cluster, però, non sono visibili. Sono visibili i dispositivi fisici ma i datastore non vengono montati da nessun nodo.

In questo caso i dispositivi vengono erroneamente interpretati come snapshot. Possiamo montarli come datastore con il comando “esxcfg-volume -M xxxx“

Verifichiamo con “esxcli storage vmfs snapshot list“:

[root@alfa:~] esxcli storage vmfs snapshot list

63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy

Volume Name: iRaid

VMFS UUID: 63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy

Can mount: true

Reason for un-mountability:

Can resignature: true

Reason for non-resignaturability:

Unresolved Extent Count: 1

63d7dc50-2758fd2c-fca2-xxxxxxxxxxxx

Volume Name: iSSD

VMFS UUID: 63d7dc50-2758fd2c-fca2-xxxxxxxxxxxx

Can mount: true

Reason for un-mountability:

Can resignature: true

Reason for non-resignaturability:

Unresolved Extent Count: 1In effetti i due dischi vengono visti come snapshot. Forziamo il mount dei datastore:

root@alfa:~] esxcfg-volume -M "63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy"

Persistently mounting volume 63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy

e

[root@alfa:~] esxcfg-volume -M "63d7dc50-2758fd2c-fca2-xxxxxxxxxxxx"

Persistently mounting volume 63d7dc50-2758fd2c-fca2-xxxxxxxxxxxxAdesso è ok