Attivazione Microsoft 365 su terminal

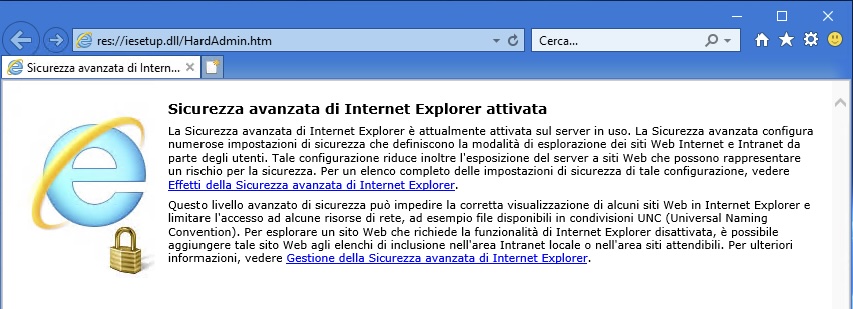

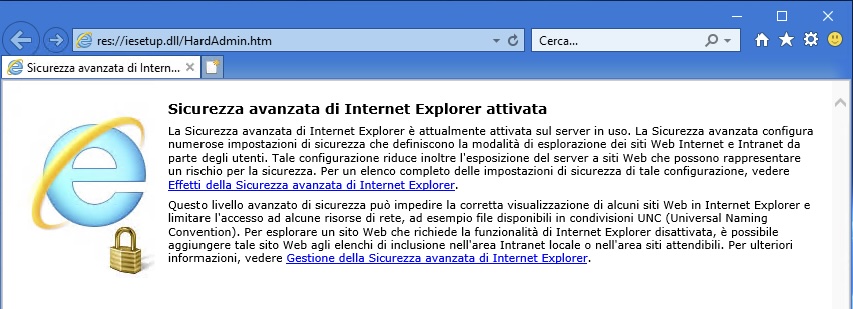

Start -> Internet Explorer

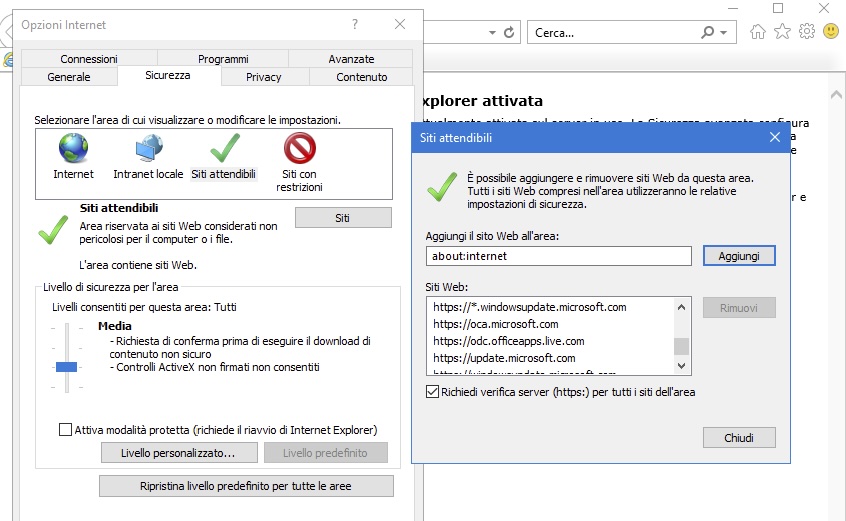

Andiamo sull’ingranaggio (Strumenti) e poi su Opzioni Internet -> tab Sicurezza -> Siti attendibili -> Siti e aggiungiamo https://odc.officeapps.live.com:

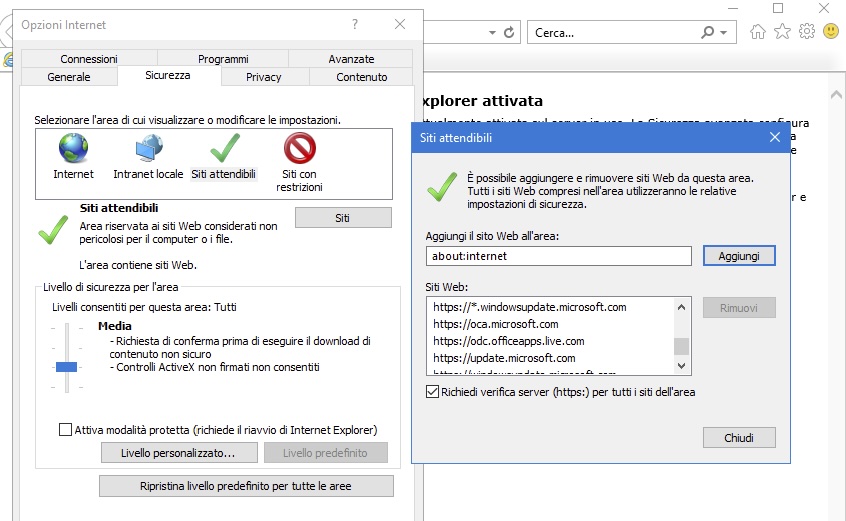

Start -> Internet Explorer

Andiamo sull’ingranaggio (Strumenti) e poi su Opzioni Internet -> tab Sicurezza -> Siti attendibili -> Siti e aggiungiamo https://odc.officeapps.live.com:

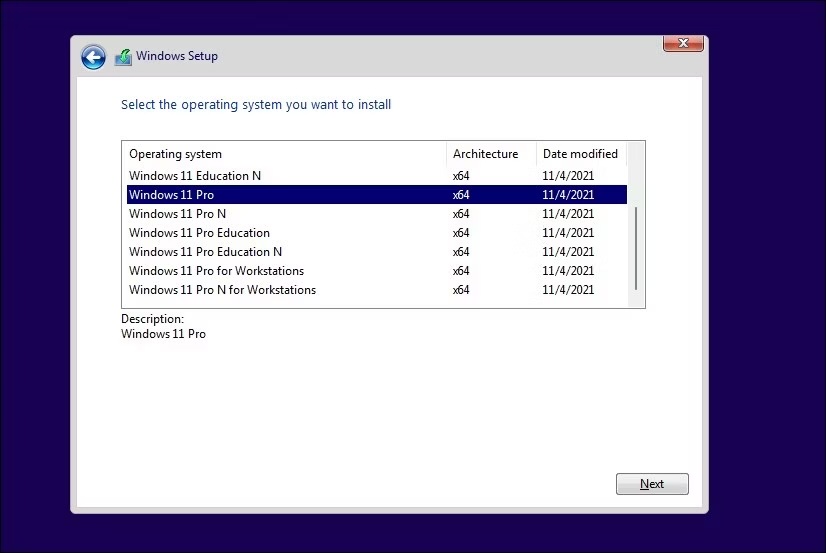

Come mai, durante l’installazione, non ci è permesso di scegliere l’edizione da installare?

Microsoft non ci permette di scegliere l’immagine ISO di installazione di Windows della versione che vogliamo ma fornisce una unica ISO che contiene tutte le edizioni disponibili.

Durante una installazione pulita il setup di Windows cerca di capire che versione dovrà installare e procederà in tal senso. Utilizza tracce delle precedenti installazioni, comprese le informazioni di licenza dell’OEM (Original Equipment Manufacturer) legate alla scheda madre (inserite nel BIOS) per determinare la licenza da installare.

Per “forzare” la scelta della versione da installare possiamo includere nel supporto di installazione un opportuno file di configurazione che forzerà la visualizzazione della schermata di selezione dell’edizione durante il Setup.

Per prima cosa dobbiamo creare un supporto USB di installazione di Windows 11 direttamente dal sito Microsoft.

A questo punto dobbiamo aprire un editor di testo (Notepad, Notepad++ o simili) e incollare questo testo:

[Channel]

_Default

[VL]

0Dobbaimo salvare il file come “ei.cfg“.

Appena creato il file apriamo il supporto di installazione, andiamo nella cartella “Sources” e copiamo li il file appena creato.

All’avvio dell’installazione il Setup ci chiederà quale versione vogliamo installare

Problema tra sistemi. Ho uno storage con TrueNAS che esporta verso un cluster due dischi iSCSI e una cartella NFS, utilizzati come datastore per le VM.

A causa di un problema con il disco di avvio dello storage ho dovuto reinstallare da zero TrueNAS, versione SCALE 23.10.0.1.

Nessun problema con la reimportazione dei volumi su TrueNAS, pochi aggiustamenti sui permessi e tutto pare tornato a posto.

I dischi iSCSI esportati verso il cluster, però, non sono visibili. Sono visibili i dispositivi fisici ma i datastore non vengono montati da nessun nodo.

In questo caso i dispositivi vengono erroneamente interpretati come snapshot. Possiamo montarli come datastore con il comando “esxcfg-volume -M xxxx“

Verifichiamo con “esxcli storage vmfs snapshot list“:

[root@alfa:~] esxcli storage vmfs snapshot list

63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy

Volume Name: iRaid

VMFS UUID: 63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy

Can mount: true

Reason for un-mountability:

Can resignature: true

Reason for non-resignaturability:

Unresolved Extent Count: 1

63d7dc50-2758fd2c-fca2-xxxxxxxxxxxx

Volume Name: iSSD

VMFS UUID: 63d7dc50-2758fd2c-fca2-xxxxxxxxxxxx

Can mount: true

Reason for un-mountability:

Can resignature: true

Reason for non-resignaturability:

Unresolved Extent Count: 1In effetti i due dischi vengono visti come snapshot. Forziamo il mount dei datastore:

root@alfa:~] esxcfg-volume -M "63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy"

Persistently mounting volume 63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy

e

[root@alfa:~] esxcfg-volume -M "63d7dc50-2758fd2c-fca2-xxxxxxxxxxxx"

Persistently mounting volume 63d7dc50-2758fd2c-fca2-xxxxxxxxxxxxAdesso è ok

Per inoltrare il traffico TCP o UDP ricevuto dall’interfaccia esterna di un FortiGate verso un server interno dobbiamo seguire questi due passi:

In questo esempio configuriamo l’inoltro di una porta per permettere l’accesso ad un server Windows interno con il protocollo RDP, che utilizza la porta di default 3389.

Per aggiungere un “virtual IP” che inoltra i pacchetti RDP:

1) Per FortiOS 6.0.x,6.2.x,7.0.x,7.2.x, Naviga su Policy & Objects -> Virtual IPs.

1.1) Seleziona Create New.

1.2) Aggiungi un nome per il virtual IP.

1.3) Seleziona l’interfaccia esterna. Solitamente questa è l’interfaccia che connette il Fortigate ad Internet.

1.4) Seleziona l’indirizzo ip o il range esterno. Si può utilizzare:

Adesso tutto quello che rimane è definire una policy sul firewall che accetta il traffico da internet e lo inoltra al server Windows interno.

Per aggiungere una regola al firewall con un virtual IP:

1) Per FortiOS 6.0, vai su Policy & Objects -> IPv4 Policy.

Per FortiOS 6.4.x,7.0.x,7.2.x, vai su Policy & Objects -> Firewall Policy.

2) Seleziona Create New.

3) Imposta Source Interface all’interfaccia WAN/Internet.

4) Imposta Source Addresses a all.

5) Imposta Destination Interface a internal.

6) Imposta Destination Address al nome del virtual IP.

7) Solitamente non è necessario modificare l’inoltro in questa policy. In questo esempio il Service può rimanere ANY, dato che il virtual IP inoltra solamente i pacchetti che utilizzano la porta 3389.

8) Seleziona OK.

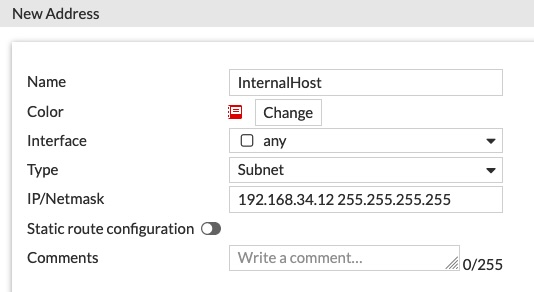

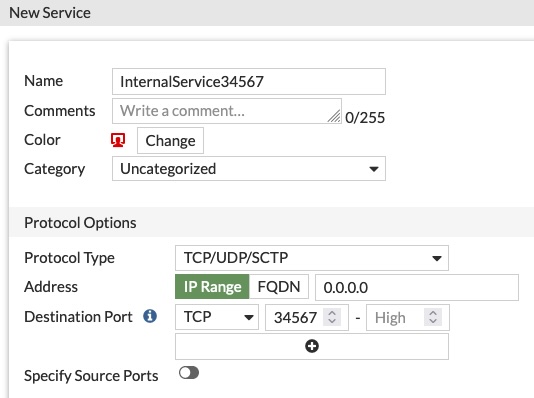

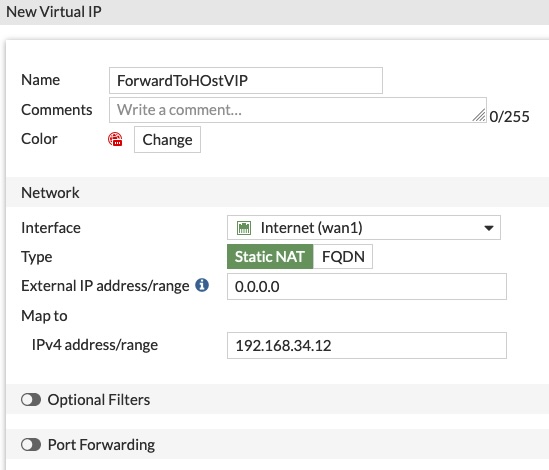

In questo esempio la rete interna è la 192.168.34.0/24, il gateway di sistema impostato sulla SD-Wan. Mettiamo su un IP interno – 192.168.34.12 – un servizio (in questo caso un server web con nginx) che ascolta sulla porta 34567 (una porta molto a caso)

Per prima cosa creiamo gli oggetti come riferimento.

Creiamo l’host: Policy & Objects -> Addresses -> Create new

Poi creiamo il riferimento per il servizio: Policy & Objects -> Services -> Create New

Quindi il Virtual IP: Policy & Objects -> Virtual IP -> Create New

Diamo un nome all’oggetto, selezioniamo l’interfaccia sorgente (WAN1) e l’ip interno su cui mappare il servizio

Attenzione: possiamo impostare l’interfaccia fisica (WAN1) e lasciare l’ip come 0.0.0.0 oppure lasciare l’interfaccia su ANY e scegliere gli ip (ip singolo o range) su cui agire.

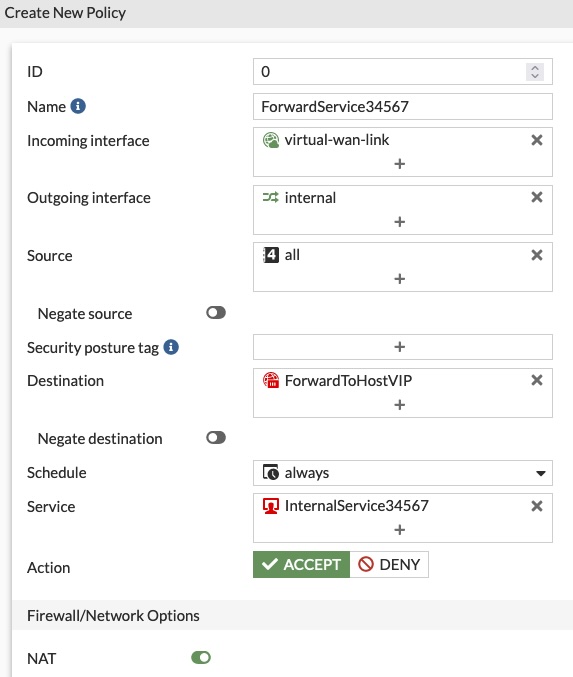

A questo punto creiamo la regola nella sezione Firewall: Policy & Objects -> Firewall Policy

Diamo un nome alla regola, poi scegliamo la “Incoming Interface“, che sarà l’interfaccia che connette il dispositivo a internet (solitamente la WAN1 oppure, come qui, la virtual-wan-link)

Selezioniamo come “Outgoing Interface” la rete di destinazione (la rete interna), il “Source” che in questo caso può essere “all” e la “Destination“, scegliendo il Virtual IP dagli oggetti (attenzione a scegliere il Virtual IP e non l’host); come servizio scegliamo, appunto, il servizio creato poco sopra. NAT è abilitato di default.

Nella connessione con un vecchio ESXi ricevo questo errore:

Unable to negotiate with ip.add.of.esxi port 22: no matching host key type found. Their offer: ssh-rsa,ssh-dss

Per permettere la connessione dobbiamo aggiungere un paio di parametri al comando:

ssh -o HostKeyAlgorithms=+ssh-rsa -o PubkeyAcceptedAlgorithms=+ssh-rsa root@ip.addressecco fatto

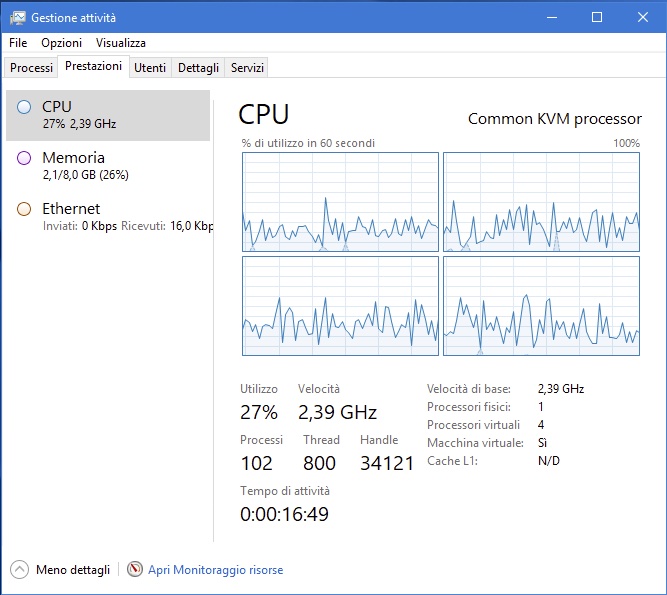

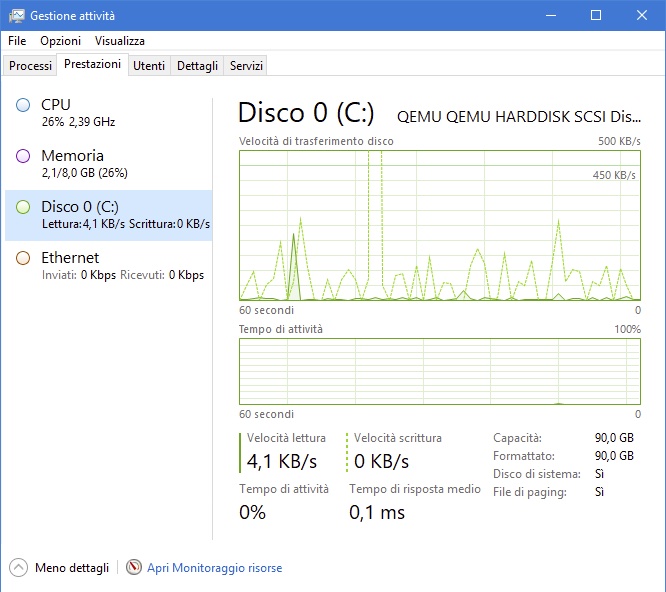

Su una nuova installazione di Windows Server, nel task manager, non viene visualizzato lo snap-in con le performance del disco:

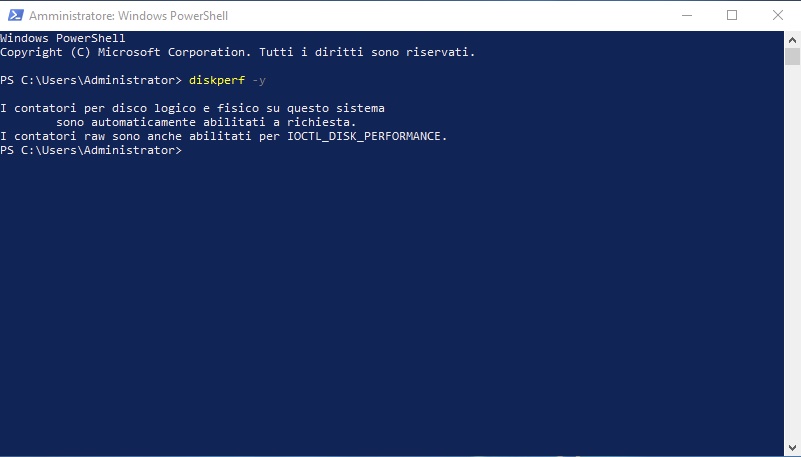

Apriamo una powershell ed inseriamo il comando:

diskperf -y

A questo punto, se apriamo nuovamente il task manager, abbiamo anche le statistiche sul disco!

Fatto!

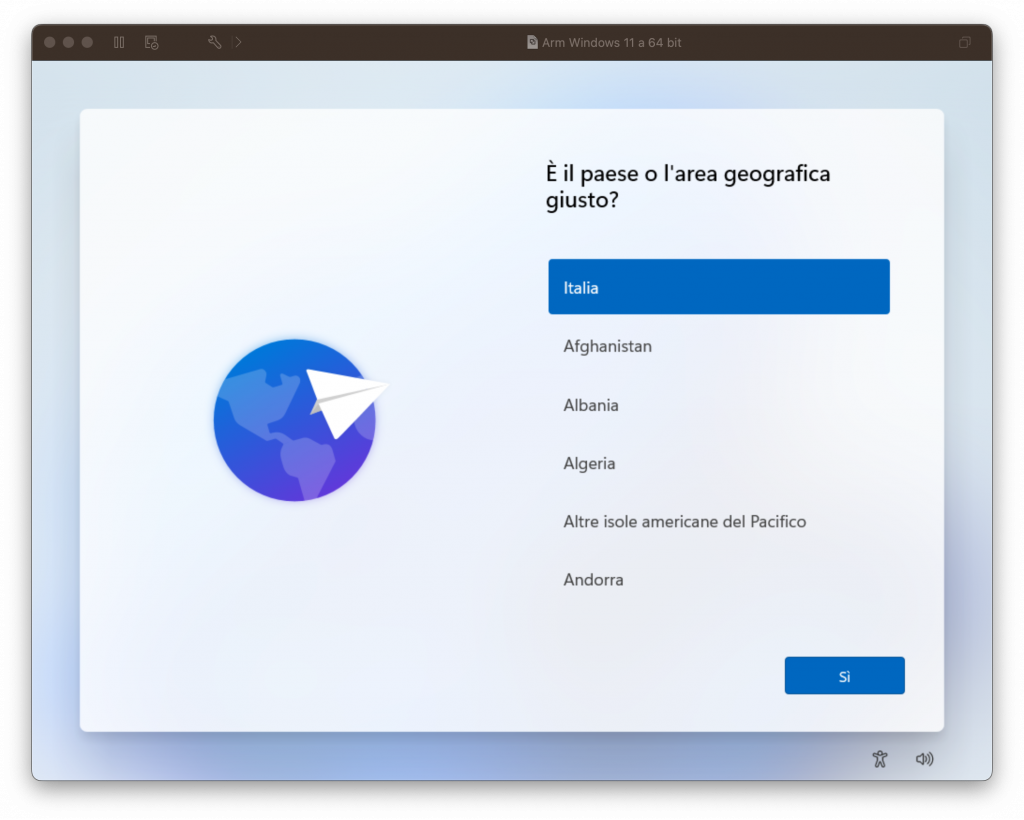

L’installazione di Windows 11 ARM su vmWare Fusion su Mac M1 (e seguenti) si blocca, dopo la scelta della tastiera, per mancanza di rete.

Per ovviare a questo problema dobbiamo eseguire una semplice procedura per installare i tools che permettono alla macchina virtuale di accedere alla rete e terminare l’installazione

Arrivati alla prima schermata:

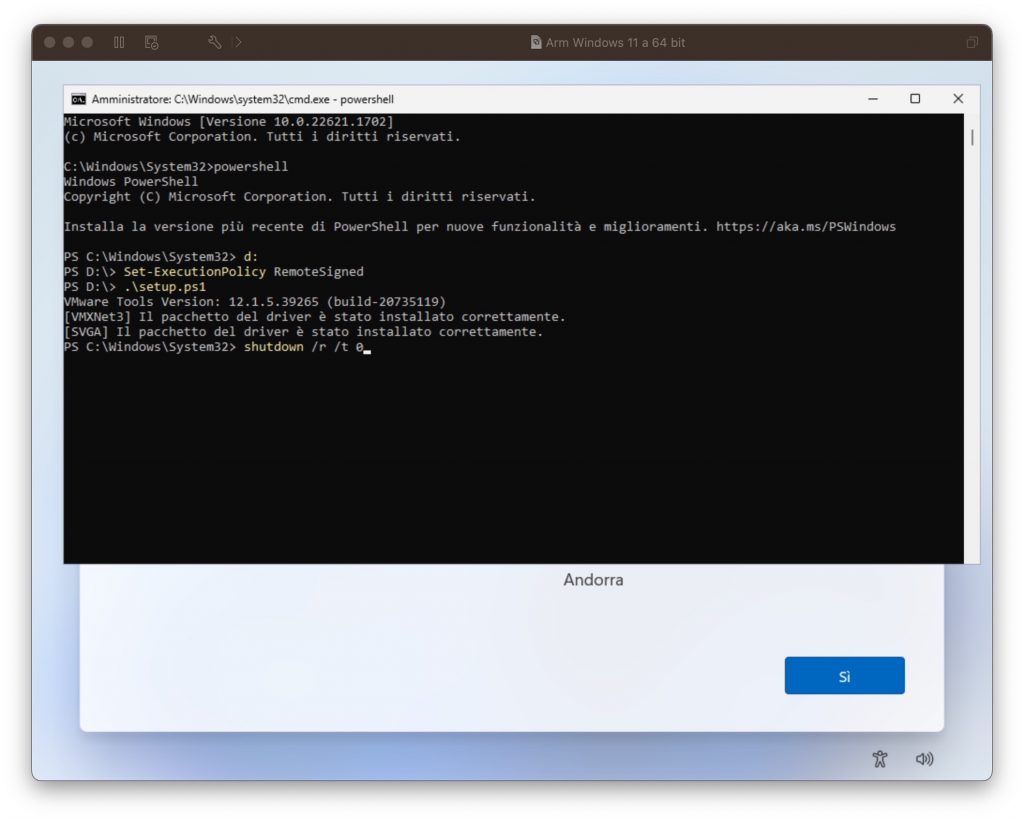

Premiamo i tasti Shift-fn-F10 per aprire un prompt dei comandi

Dal prompt dei comandi digitiamo:

powershelle da qui eseguiamo:

D:

Set-ExecutionPolicy RemoteSigned

.\setup.ps1Al termine riavviamo la macchina che, al seguente avvio, potrà effettuare l’installazione regolarmente:

shutdown /r /t 0

Fatto 🙂

Qui i riferimenti

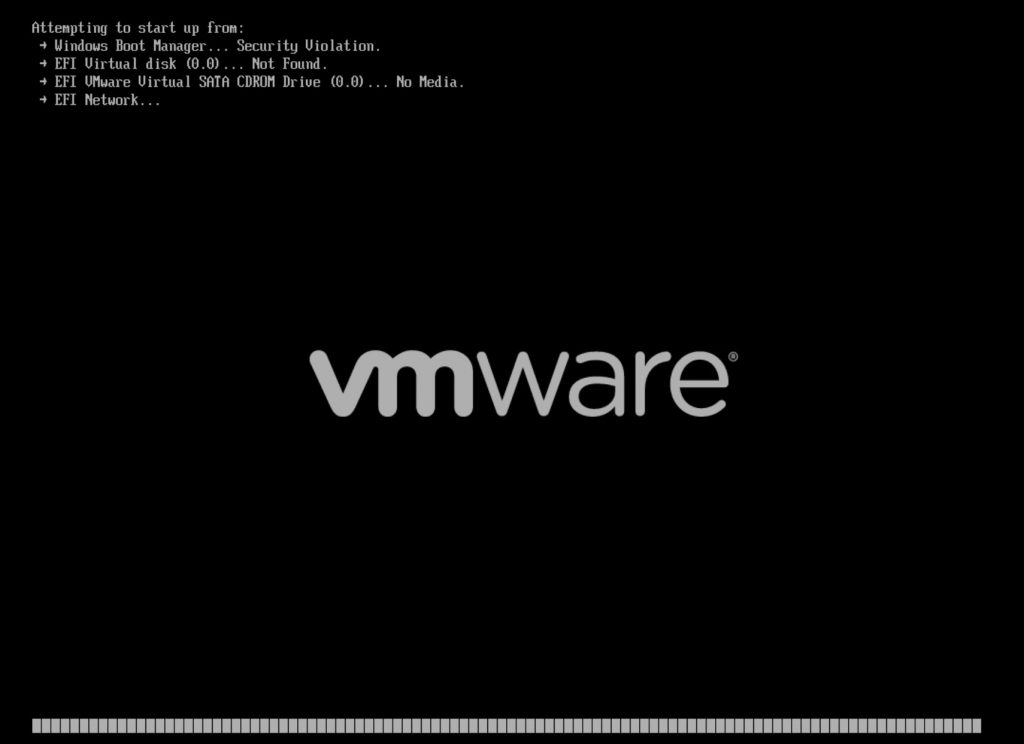

L’installazione di un aggiornamento cumulativo (2023-02 Cumulative Update for Microsoft server operating system version 21H2 for x64-based Systems (KB5022842)) impedisce il corretto avvio della VM:

Al momento non ci sono soluzioni ne da parte di vmware ne da parte di Microsoft.

I consigli sono essenzialmente due: non installare la patch oppure disabilitare l’avvio sicuro.

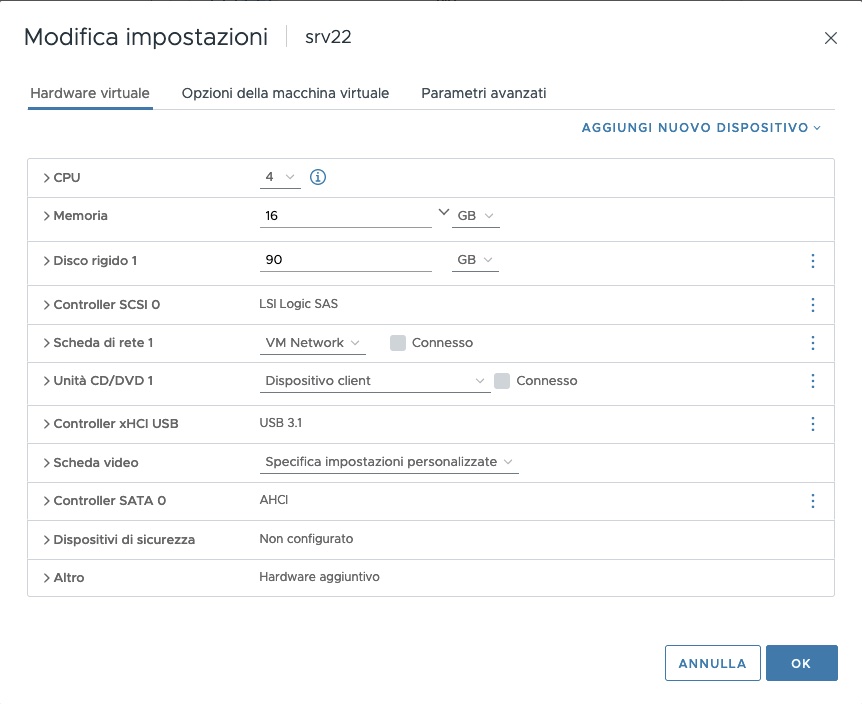

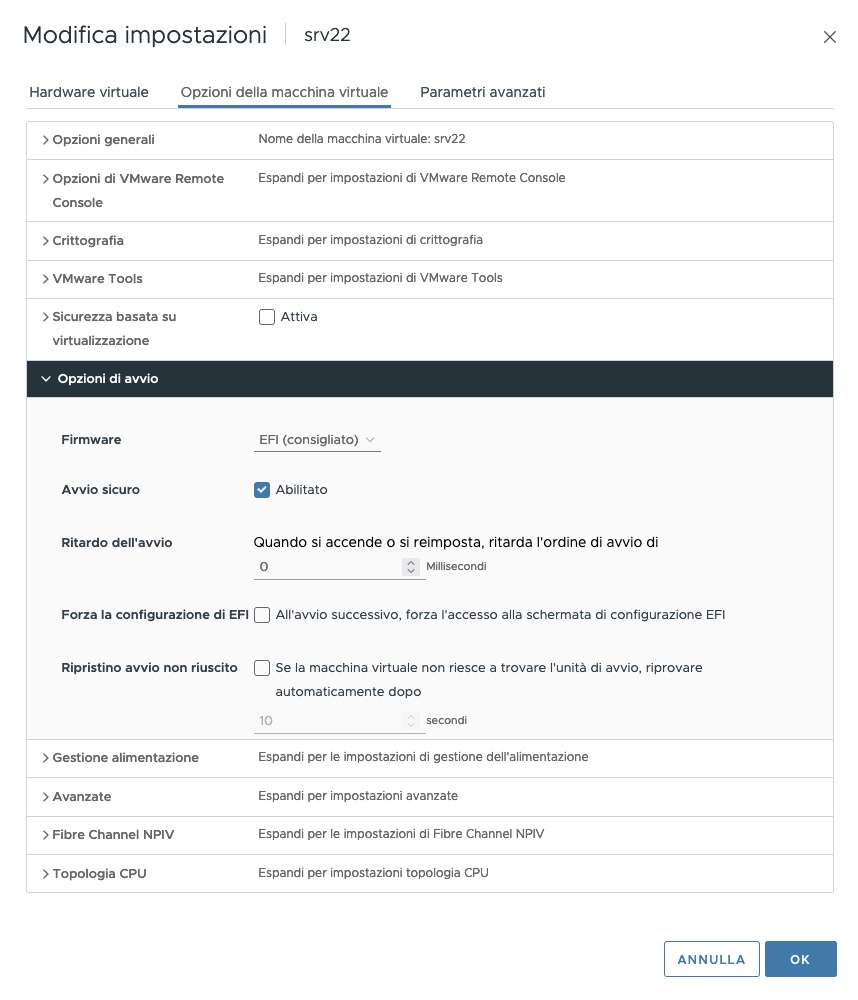

Per disabilitare l’avvio sicuro dobbiamo andare sulle impostazioni della macchina virtuale:

e disabilitare l’opzione “Avvio sicuro” nelle opzioni di avvio

Il corretto dimensionamento di un server che ospita Proxmox non dovrebbe coinvolgere l’utilizzo dello spazio di swap.

Capita però che sia necessario aggiungere dello spazio di swap quando la memoria non è sufficiente e dobbiamo tamponare la situazione, in attesa di espandere la memoria principale.

Capita infatti che l’OOM uccida un processo (e se vi siete posti il problema probabilmente era una VM in funzione) prima di rendere il sistema instabile.

In questo caso possiamo aggiungere uno spazio di swap per limitare il problema.

E’ buona norma dedicare una partizione allo swap e non impasticciare su filesystem esistenti ma a volte si procede per emergenze.

In questo caso creiamo uno spazio di swap da 24GB come ZVOL:

# zfs create rpool/swapspace -V 24G

verifichiamo con:

# zpool status

e:

# zfs list

# mkswap /dev/rpool/swapspace

# swapon /dev/rpool/swapspace

# freePer evitare che lo spazio di swap venga utilizzato senza una vera e stringente necessità possiamo impostare il parametro “swappiness”:

# sysctl -w vm.swappiness=10E per renderlo effettivo al riavvio aggiungiamo una linea al file “/etc/sysctl.conf”

vm.swappiness = 10Per aggiungere lo spazio di swap al file “/etc/fstab” aggiungiamo la seguente riga:

/dev/rpool/swapspace none swap defaults 0 0fatto

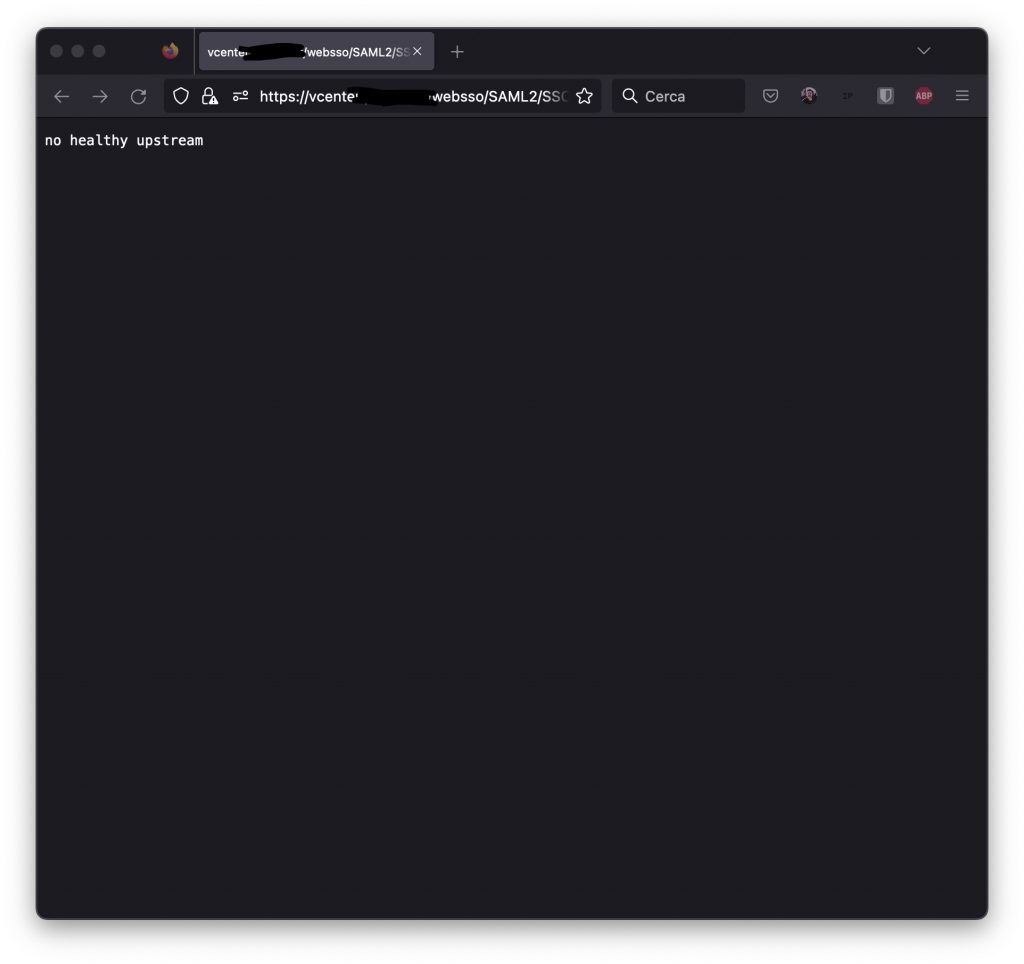

Tra le migliaia di cause per questo dannato errore di “no healthy upstream” c’è anche la possibilità che i certificati interni siano scaduti.

Ci troviamo con una pagina bianca (o scura, a seconda del tema…) e la sola dicitura “no healthy upstream”:

Tra le possibili soluzioni, prima di tentare una reinstallazione completa del vCenter, verifichiamo che i certificati siano ok. Da una sessione SSH proviamo a fare un controllo

root@vcenter [ /etc/vmware/vsphere-ui ]# for store in $(/usr/lib/vmware-vmafd/bin/vecs-cli store list | grep -v TRUSTED_ROOT_CRLS); do echo "[*] Store :" $store; /usr/lib/vmware-vmafd/bin/vecs-cli entry list --store $store --text | grep -ie "Alias" -ie "Not After";done;Otteniamo un elenco dei certificati e delle scadenze

[*] Store : MACHINE_SSL_CERT

Alias : __MACHINE_CERT

Not After : Nov 1 10:26:08 2022 GMT

[*] Store : TRUSTED_ROOTS

Alias : b88fd8df2674612aaadccbac0140ace59464a9d0

Not After : Oct 26 22:26:08 2030 GMT

[*] Store : machine

Alias : machine

Not After : Oct 26 22:26:08 2030 GMT

[*] Store : vsphere-webclient

Alias : vsphere-webclient

Not After : Oct 26 22:26:08 2030 GMT

[*] Store : vpxd

Alias : vpxd

Not After : Oct 26 22:26:08 2030 GMT

[*] Store : vpxd-extension

Alias : vpxd-extension

Not After : Oct 26 22:26:08 2030 GMT

[*] Store : hvc

Alias : hvc

Not After : Oct 26 22:26:08 2030 GMT

[*] Store : data-encipherment

Alias : data-encipherment

Not After : Oct 26 22:26:08 2030 GMT

[*] Store : APPLMGMT_PASSWORD

[*] Store : SMS

Alias : sms_self_signed

Not After : Oct 31 22:31:21 2030 GMT

[*] Store : wcp

Alias : wcp

Not After : Oct 31 22:23:31 2022 GMTCi sono un paio di certificati scaduti, dannato mondo. Andiamo nella cartella /usr/lib/vmware-vmca/bin e eseguiamo il certificate-manager

root@vcenter [ /usr/lib/vmware-vmca/bin ]# ./certificate-manager

_ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _

| |

| *** Welcome to the vSphere 6.8 Certificate Manager *** |

| |

| -- Select Operation -- |

| |

| 1. Replace Machine SSL certificate with Custom Certificate |

| |

| 2. Replace VMCA Root certificate with Custom Signing |

| Certificate and replace all Certificates |

| |

| 3. Replace Machine SSL certificate with VMCA Certificate |

| |

| 4. Regenerate a new VMCA Root Certificate and |

| replace all certificates |

| |

| 5. Replace Solution user certificates with |

| Custom Certificate |

| NOTE: Solution user certs will be deprecated in a future |

| release of vCenter. Refer to release notes for more details.|

| |

| 6. Replace Solution user certificates with VMCA certificates |

| |

| 7. Revert last performed operation by re-publishing old |

| certificates |

| |

| 8. Reset all Certificates |

|_ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _|

Note : Use Ctrl-D to exit.

Option[1 to 8]: 8Resettiamo tutto con l’opzione “8”, se serve possiamo:

# service-control --stop vsphere-ui

# service-control --start vsphere-uiDovrebbe essere tutto ok 🙂