Applicazioni Windows

Lista “comoda” di applicazioni windows utili (Windows client)

DWMBlurGlass

YASB

xxx

Lista “comoda” di applicazioni windows utili (Windows client)

DWMBlurGlass

YASB

xxx

Come troviamo il dispositivo fisico corrispondente all’etichetta \Device\Harddisk ecc. ecc.???

Quella è, per esempio, l’etichetta che troviamo nei log con gli errori disco nella visualizzazione eventi.

Da una sessione PowerShell eseguiamo il comando:

Get-PhysicalDisk | Select -Prop DeviceId,FriendlyName,SerialNumberL’output del comando sarà simile a questo:

DeviceId FriendlyName SerialNumber

-------- ------------ ------------

1 ST1000DM003 xxxxxxxx

5 ST1000DM003 yyyyyyyy

2 ST1000DM003 zzzzzzzz

0 Corsair Force LS SSD aaaaaaaaaaaaaa

4 WDC WD10EFRX-68PJCN0 bbbbbbbbbbbbbb

3 Samsung SSD 980 PRO 256GB ccccccccccccccIl DeviceID corrisponde al disco che vediamo sull’etichetta, nella path 🙂

Classico server debian o proxmox con installazione base. L’invio delle mail di sistema rimbalza tra il server smtp, la destinazione e chissà cos’altro.

Facciamo le cose per bene e utilizziamo un SMTP autenticato, con la riscrittura del FROM:, quando il nostro caro sistema sembra fare quello che vuole.

Per prima cosa installiamo le librerie necessarie:

apt-get install libsasl2-2 libsasl2-modulesPrepariamo il file /etc/postfix/sasl/password con i dati di autenticazione al nostro SMTP

nostro.smtp.server utente@nostro.smtp.server:_password_Prepariamo il file /etc/postfix/header_check, che contiene il replace da eseguire nell’header delle mail in uscita

/From:.*/ REPLACE From: utente@nostro.smtp.servere prepariamo anche il file /etc/postfix/generic, con gli altri eventuali mapping

root@server.local utente@nostro.smtp.serverCompiliamo i file appena creati/modificati

postmap /etc/postfix/sasl/password

postmap /etc/postfix/header_check

postmap /etc/postfix/generica questo punto modifichiamo /etc/postfix/main.cf

smtp_header_checks = regexp:/etc/postfix/header_check

smtp_generic_maps = hash:/etc/postfix/generic

relayhost = nostro.smtp.server:587

smtp_use_tls = yes

smtp_sasl_auth_enable = yes

smtp_sasl_password_maps = hash:/etc/postfix/sasl/password

smtp_sasl_security_options =mettiamoci in coda al giornale di sistema per vedere cosa abbiamo combinato

journalctl -fe riavviamo il postfix con

/etc/init.d/postfix restartadesso proviamo ad inviare una mail dalla shell e vediamo se tutto funziona

echo "Prova di invio mail" | mail -s "prova" destinazione@da.qualche.parteArrivata?

Ecco una lista delle mie applicazioni MacOS preferite

Bartender, utility per la gestione delle icone del menù

Hidden, per la gestione delle icone del menù

iStat Menu, il menù più dettagliato

MonitorControl, per gestire i monitor esterni

BetterDisplay, gestione monitor esterni on steroids 🙂

OpenEmu, emulazione retro

Shottr, per gli screenshot

Stats, per le statistiche più nerd

PDFgear, Gestione dei pdf

Transnomio, per rinominare file, tanti file

ImageOptim, ottimizzatore di immagini

Paparazzi, per fare screenshot di pagine web

uBar4 una docking bar stile finestre

cDock a better dock per macOS

xxx

xxx

If you are experiencing issues with your Unifi Access Point (AP), it may be necessary to perform a factory reset. This process will erase all of the configuration settings and restore the device to its default state. In this article, we will walk you through the steps to factory reset a Unifi AP using SSH.

To begin, you will need to connect to the Unifi AP using SSH. You can use any SSH client to do this, such as PuTTY or Terminal. Once you have opened your SSH client, enter the IP address of the Unifi AP and click “Connect.”

After you have connected to the Unifi AP via SSH, you will need to log in using your Unifi username and password. If you have not changed the default login credentials, the username is “ubnt” and the password is “ubnt.”

Once you have logged in to the Unifi AP, you can enter the factory reset command. The command is as follows:

syswrapper.sh restore-default & set-default &

After you have entered the command, press “Enter” to execute it. The Unifi AP will then begin the factory reset process.

The factory reset process may take a few minutes to complete. During this time, the Unifi AP will reboot and erase all of the configuration settings. Once the process is complete, you will be able to log in to the Unifi AP using the default login credentials.

After the factory reset is complete, you will need to reconfigure the Unifi AP with your desired settings. This includes setting up your wireless network, creating new login credentials, and configuring any other settings that you require.

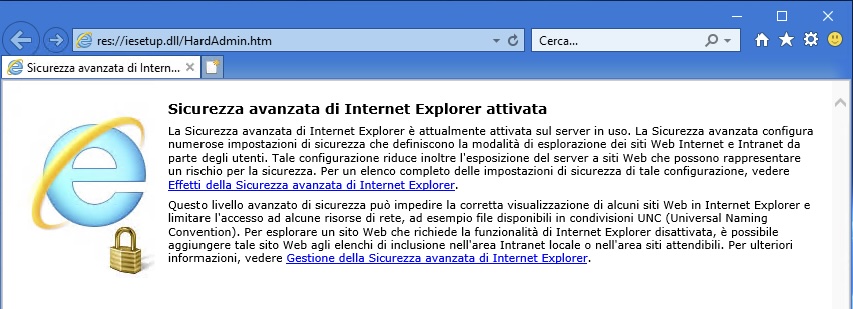

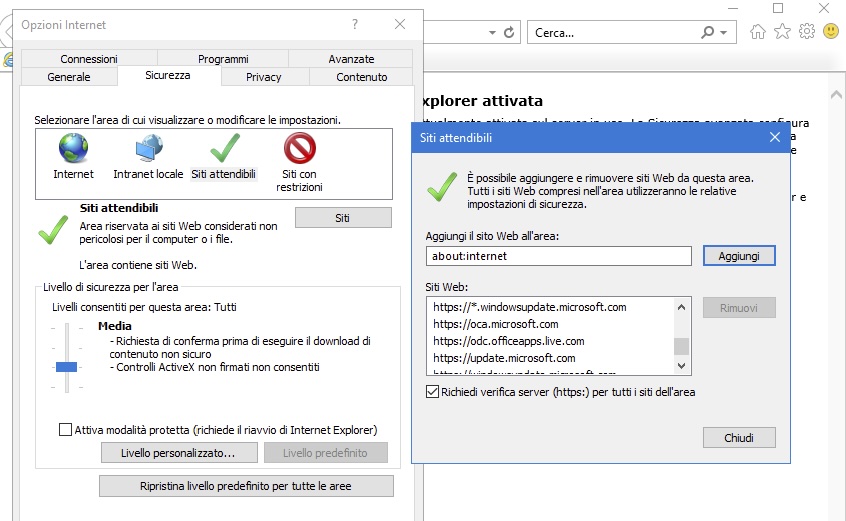

Start -> Internet Explorer

Andiamo sull’ingranaggio (Strumenti) e poi su Opzioni Internet -> tab Sicurezza -> Siti attendibili -> Siti e aggiungiamo https://odc.officeapps.live.com:

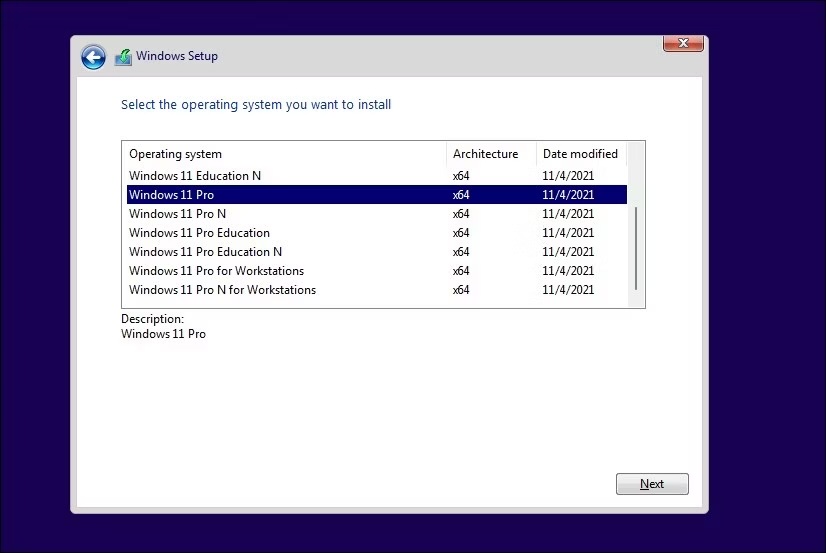

Come mai, durante l’installazione, non ci è permesso di scegliere l’edizione da installare?

Microsoft non ci permette di scegliere l’immagine ISO di installazione di Windows della versione che vogliamo ma fornisce una unica ISO che contiene tutte le edizioni disponibili.

Durante una installazione pulita il setup di Windows cerca di capire che versione dovrà installare e procederà in tal senso. Utilizza tracce delle precedenti installazioni, comprese le informazioni di licenza dell’OEM (Original Equipment Manufacturer) legate alla scheda madre (inserite nel BIOS) per determinare la licenza da installare.

Per “forzare” la scelta della versione da installare possiamo includere nel supporto di installazione un opportuno file di configurazione che forzerà la visualizzazione della schermata di selezione dell’edizione durante il Setup.

Per prima cosa dobbiamo creare un supporto USB di installazione di Windows 11 direttamente dal sito Microsoft.

A questo punto dobbiamo aprire un editor di testo (Notepad, Notepad++ o simili) e incollare questo testo:

[Channel]

_Default

[VL]

0Dobbaimo salvare il file come “ei.cfg“.

Appena creato il file apriamo il supporto di installazione, andiamo nella cartella “Sources” e copiamo li il file appena creato.

All’avvio dell’installazione il Setup ci chiederà quale versione vogliamo installare

Problema tra sistemi. Ho uno storage con TrueNAS che esporta verso un cluster due dischi iSCSI e una cartella NFS, utilizzati come datastore per le VM.

A causa di un problema con il disco di avvio dello storage ho dovuto reinstallare da zero TrueNAS, versione SCALE 23.10.0.1.

Nessun problema con la reimportazione dei volumi su TrueNAS, pochi aggiustamenti sui permessi e tutto pare tornato a posto.

I dischi iSCSI esportati verso il cluster, però, non sono visibili. Sono visibili i dispositivi fisici ma i datastore non vengono montati da nessun nodo.

In questo caso i dispositivi vengono erroneamente interpretati come snapshot. Possiamo montarli come datastore con il comando “esxcfg-volume -M xxxx“

Verifichiamo con “esxcli storage vmfs snapshot list“:

[root@alfa:~] esxcli storage vmfs snapshot list

63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy

Volume Name: iRaid

VMFS UUID: 63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy

Can mount: true

Reason for un-mountability:

Can resignature: true

Reason for non-resignaturability:

Unresolved Extent Count: 1

63d7dc50-2758fd2c-fca2-xxxxxxxxxxxx

Volume Name: iSSD

VMFS UUID: 63d7dc50-2758fd2c-fca2-xxxxxxxxxxxx

Can mount: true

Reason for un-mountability:

Can resignature: true

Reason for non-resignaturability:

Unresolved Extent Count: 1In effetti i due dischi vengono visti come snapshot. Forziamo il mount dei datastore:

root@alfa:~] esxcfg-volume -M "63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy"

Persistently mounting volume 63d4ea88-32fcf386-7e0e-yyyyyyyyyyyy

e

[root@alfa:~] esxcfg-volume -M "63d7dc50-2758fd2c-fca2-xxxxxxxxxxxx"

Persistently mounting volume 63d7dc50-2758fd2c-fca2-xxxxxxxxxxxxAdesso è ok

Per inoltrare il traffico TCP o UDP ricevuto dall’interfaccia esterna di un FortiGate verso un server interno dobbiamo seguire questi due passi:

In questo esempio configuriamo l’inoltro di una porta per permettere l’accesso ad un server Windows interno con il protocollo RDP, che utilizza la porta di default 3389.

Per aggiungere un “virtual IP” che inoltra i pacchetti RDP:

1) Per FortiOS 6.0.x,6.2.x,7.0.x,7.2.x, Naviga su Policy & Objects -> Virtual IPs.

1.1) Seleziona Create New.

1.2) Aggiungi un nome per il virtual IP.

1.3) Seleziona l’interfaccia esterna. Solitamente questa è l’interfaccia che connette il Fortigate ad Internet.

1.4) Seleziona l’indirizzo ip o il range esterno. Si può utilizzare:

Adesso tutto quello che rimane è definire una policy sul firewall che accetta il traffico da internet e lo inoltra al server Windows interno.

Per aggiungere una regola al firewall con un virtual IP:

1) Per FortiOS 6.0, vai su Policy & Objects -> IPv4 Policy.

Per FortiOS 6.4.x,7.0.x,7.2.x, vai su Policy & Objects -> Firewall Policy.

2) Seleziona Create New.

3) Imposta Source Interface all’interfaccia WAN/Internet.

4) Imposta Source Addresses a all.

5) Imposta Destination Interface a internal.

6) Imposta Destination Address al nome del virtual IP.

7) Solitamente non è necessario modificare l’inoltro in questa policy. In questo esempio il Service può rimanere ANY, dato che il virtual IP inoltra solamente i pacchetti che utilizzano la porta 3389.

8) Seleziona OK.

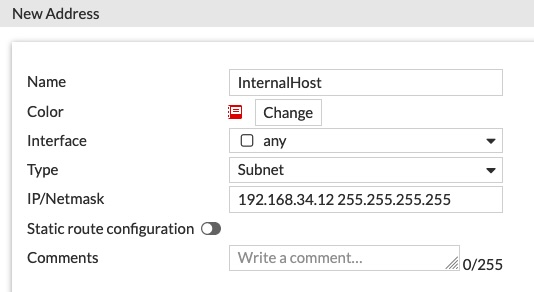

In questo esempio la rete interna è la 192.168.34.0/24, il gateway di sistema impostato sulla SD-Wan. Mettiamo su un IP interno – 192.168.34.12 – un servizio (in questo caso un server web con nginx) che ascolta sulla porta 34567 (una porta molto a caso)

Per prima cosa creiamo gli oggetti come riferimento.

Creiamo l’host: Policy & Objects -> Addresses -> Create new

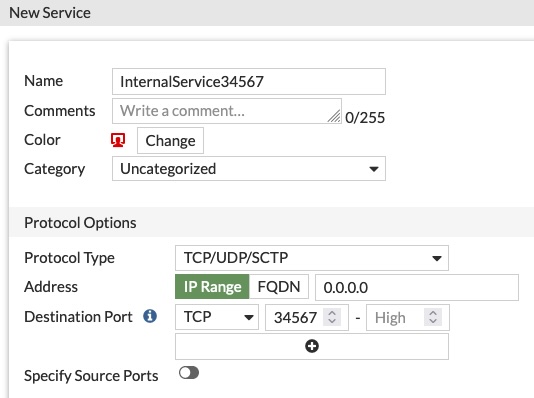

Poi creiamo il riferimento per il servizio: Policy & Objects -> Services -> Create New

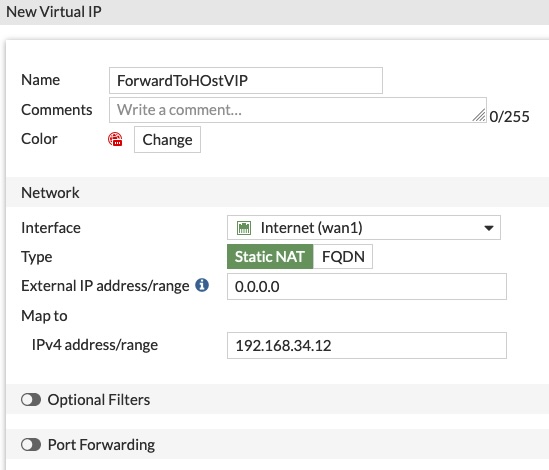

Quindi il Virtual IP: Policy & Objects -> Virtual IP -> Create New

Diamo un nome all’oggetto, selezioniamo l’interfaccia sorgente (WAN1) e l’ip interno su cui mappare il servizio

Attenzione: possiamo impostare l’interfaccia fisica (WAN1) e lasciare l’ip come 0.0.0.0 oppure lasciare l’interfaccia su ANY e scegliere gli ip (ip singolo o range) su cui agire.

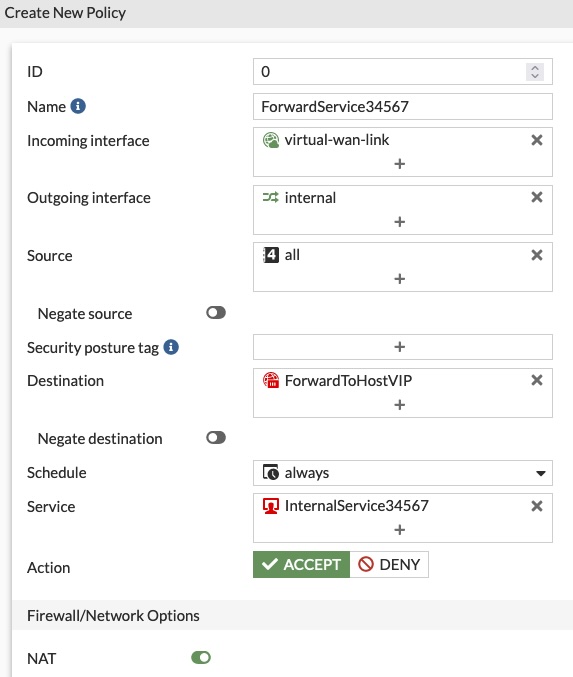

A questo punto creiamo la regola nella sezione Firewall: Policy & Objects -> Firewall Policy

Diamo un nome alla regola, poi scegliamo la “Incoming Interface“, che sarà l’interfaccia che connette il dispositivo a internet (solitamente la WAN1 oppure, come qui, la virtual-wan-link)

Selezioniamo come “Outgoing Interface” la rete di destinazione (la rete interna), il “Source” che in questo caso può essere “all” e la “Destination“, scegliendo il Virtual IP dagli oggetti (attenzione a scegliere il Virtual IP e non l’host); come servizio scegliamo, appunto, il servizio creato poco sopra. NAT è abilitato di default.

Nella connessione con un vecchio ESXi ricevo questo errore:

Unable to negotiate with ip.add.of.esxi port 22: no matching host key type found. Their offer: ssh-rsa,ssh-dss

Per permettere la connessione dobbiamo aggiungere un paio di parametri al comando:

ssh -o HostKeyAlgorithms=+ssh-rsa -o PubkeyAcceptedAlgorithms=+ssh-rsa root@ip.addressecco fatto